QwQ-32B

匹配R1推理能力,但体积缩小了20倍

2025-03-07

来自阿里巴巴Qwen团队的QwQ-32B,是一种新的开源32B LLM,通过规模化的强化学习实现了DeepSeek-R1级别的推理能力。具备针对复杂任务的'思维模式'。

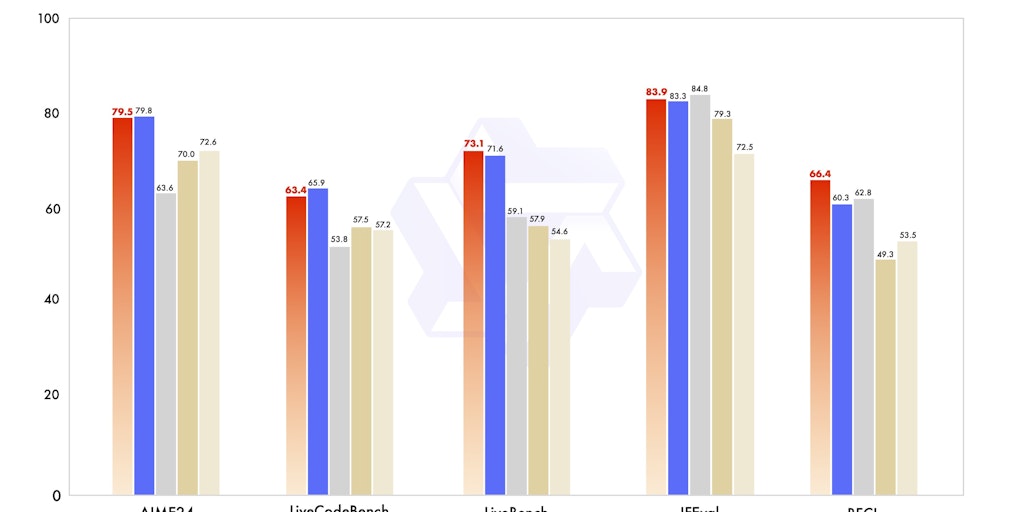

由阿里巴巴的Qwen团队开发的QwQ-32B,是一款前沿的320亿参数开源语言模型,专为高级推理任务设计。利用规模化强化学习,它在推理能力上能够与DeepSeek-R1等领先模型匹敌,同时体积小了20倍。其独特的“思维模式”增强了复杂问题上的表现,使其成为需要深度分析任务的理想选择。基于Qwen2.5架构构建,它配备了RoPE、SwiGLU和RMSNorm等先进组件,支持长达131,072个标记的上下文长度。QwQ-32B在多轮对话、长上下文理解以及数学问题和选择题等任务的标准化输出方面表现出色。针对Hugging Face和vLLM等框架进行了优化,它在效率和高性能之间提供了平衡,成为开发者应对挑战性AI应用的强大工具。

Open Source

Artificial Intelligence